This article is about signal processing and relation of spectra to time-series. For further applications in the physical sciences, see Spectrum § Physical science.

«Spectral power density» redirects here. Not to be confused with Spectral power.

The spectral density of a fluorescent light as a function of optical wavelength shows peaks at atomic transitions, indicated by the numbered arrows.

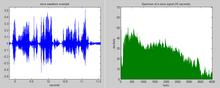

The voice waveform over time (left) has a broad audio power spectrum (right).

The power spectrum

When the energy of the signal is concentrated around a finite time interval, especially if its total energy is finite, one may compute the energy spectral density. More commonly used is the power spectral density (or simply power spectrum), which applies to signals existing over all time, or over a time period large enough (especially in relation to the duration of a measurement) that it could as well have been over an infinite time interval. The power spectral density (PSD) then refers to the spectral energy distribution that would be found per unit time, since the total energy of such a signal over all time would generally be infinite. Summation or integration of the spectral components yields the total power (for a physical process) or variance (in a statistical process), identical to what would be obtained by integrating

The spectrum of a physical process

However this article concentrates on situations in which the time series is known (at least in a statistical sense) or directly measured (such as by a microphone sampled by a computer). The power spectrum is important in statistical signal processing and in the statistical study of stochastic processes, as well as in many other branches of physics and engineering. Typically the process is a function of time, but one can similarly discuss data in the spatial domain being decomposed in terms of spatial frequency.[1]

Units[edit]

In physics, the signal might be a wave, such as an electromagnetic wave, an acoustic wave, or the vibration of a mechanism. The power spectral density (PSD) of the signal describes the power present in the signal as a function of frequency, per unit frequency. Power spectral density is commonly expressed in watts per hertz (W/Hz).[2]

When a signal is defined in terms only of a voltage, for instance, there is no unique power associated with the stated amplitude. In this case «power» is simply reckoned in terms of the square of the signal, as this would always be proportional to the actual power delivered by that signal into a given impedance. So one might use units of V2 Hz−1 for the PSD. Energy spectral density (ESD) would have units would be V2 s Hz−1, since energy has units of power multiplied by time (e.g., watt-hour).[3]

In the general case, the units of PSD will be the ratio of units of variance per unit of frequency; so, for example, a series of displacement values (in meters) over time (in seconds) will have PSD in units of meters squared per hertz, m2/Hz.

In the analysis of random vibrations, units of g2 Hz−1 are frequently used for the PSD of acceleration, where g denotes the g-force.[4]

Mathematically, it is not necessary to assign physical dimensions to the signal or to the independent variable. In the following discussion the meaning of x(t) will remain unspecified, but the independent variable will be assumed to be that of time.

Definition[edit]

Energy spectral density[edit]

«Energy spectral density» redirects here. Not to be confused with energy spectrum.

Energy spectral density describes how the energy of a signal or a time series is distributed with frequency. Here, the term energy is used in the generalized sense of signal processing;[5] that is, the energy

The energy spectral density is most suitable for transients—that is, pulse-like signals—having a finite total energy. Finite or not, Parseval’s theorem[6] (or Plancherel’s theorem) gives us an alternate expression for the energy of the signal:

where:

is the value of the Fourier transform of

Therefore, the energy spectral density of

|

|

(Eq.1) |

The function

As a physical example of how one might measure the energy spectral density of a signal, suppose

This definition generalizes in a straightforward manner to a discrete signal with a countably infinite number of values

where

Power spectral density[edit]

The above definition of energy spectral density is suitable for transients (pulse-like signals) whose energy is concentrated around one time window; then the Fourier transforms of the signals generally exist. For continuous signals over all time, one must rather define the power spectral density (PSD) which exists for stationary processes; this describes how the power of a signal or time series is distributed over frequency, as in the simple example given previously. Here, power can be the actual physical power, or more often, for convenience with abstract signals, is simply identified with the squared value of the signal. For example, statisticians study the variance of a function over time

The average power

However, for the sake of dealing with the math that follows, it is more convenient to deal with time limits in the signal itself rather than time limits in the bounds of the integral. As such, we have an alternative representation of the average power, where

Clearly in cases where the above expression for P is non-zero (even as T grows without bound) the integral itself must also grow without bound. That is the reason that we cannot use the energy spectral density itself, which is that diverging integral, in such cases.

In analyzing the frequency content of the signal

Then the power spectral density is simply defined as the integrand above.[8][9]

|

|

(Eq.2) |

From here, we can also view

Now, if we divide the time convolution above by the period

From here we see, again assuming the ergodicity of

|

|

(Eq.3) |

Many authors use this equality to actually define the power spectral density.[11]

The power of the signal in a given frequency band ![[f_{1},f_{2}]](https://wikimedia.org/api/rest_v1/media/math/render/svg/1ce110719ca89eeeac9a2786c1fce4e86800dd41)

More generally, similar techniques may be used to estimate a time-varying spectral density. In this case the time interval

Just as with the energy spectral density, the definition of the power spectral density can be generalized to discrete time variables

Note that a single estimate of the PSD can be obtained through a finite number of samplings. As before, the actual PSD is achieved when

If two signals both possess power spectral densities, then the cross-spectral density can similarly be calculated; as the PSD is related to the autocorrelation, so is the cross-spectral density related to the cross-correlation.

Properties of the power spectral density[edit]

Some properties of the PSD include:[13]

Cross power spectral density [edit]

Given two signals

Using the same notation and methods as used for the power spectral density derivation, we exploit Parseval’s theorem and obtain

where, again, the contributions of

where

For discrete signals xn and yn, the relationship between the cross-spectral density and the cross-covariance is

Estimation[edit]

The goal of spectral density estimation is to estimate the spectral density of a random signal from a sequence of time samples. Depending on what is known about the signal, estimation techniques can involve parametric or non-parametric approaches, and may be based on time-domain or frequency-domain analysis. For example, a common parametric technique involves fitting the observations to an autoregressive model. A common non-parametric technique is the periodogram.

The spectral density is usually estimated using Fourier transform methods (such as the Welch method), but other techniques such as the maximum entropy method can also be used.

[edit]

- The spectral centroid of a signal is the midpoint of its spectral density function, i.e. the frequency that divides the distribution into two equal parts.

- The spectral edge frequency (SEF), usually expressed as «SEF x«, represents the frequency below which x percent of the total power of a given signal are located; typically, x is in the range 75 to 95. It is more particularly a popular measure used in EEG monitoring, in which case SEF has variously been used to estimate the depth of anesthesia and stages of sleep.[16][17][18]

- A spectral envelope is the envelope curve of the spectrum density. It describes one point in time (one window, to be precise). For example, in remote sensing using a spectrometer, the spectral envelope of a feature is the boundary of its spectral properties, as defined by the range of brightness levels in each of the spectral bands of interest.[19]

- The spectral density is a function of frequency, not a function of time. However, the spectral density of a small window of a longer signal may be calculated, and plotted versus time associated with the window. Such a graph is called a spectrogram. This is the basis of a number of spectral analysis techniques such as the short-time Fourier transform and wavelets.

- A «spectrum» generally means the power spectral density, as discussed above, which depicts the distribution of signal content over frequency. For transfer functions (e.g., Bode plot, chirp) the complete frequency response may be graphed in two parts: power versus frequency and phase versus frequency—the phase spectral density, phase spectrum, or spectral phase. Less commonly, the two parts may be the real and imaginary parts of the transfer function. This is not to be confused with the frequency response of a transfer function, which also includes a phase (or equivalently, a real and imaginary part) as a function of frequency. The time-domain impulse response

cannot generally be uniquely recovered from the power spectral density alone without the phase part. Although these are also Fourier transform pairs, there is no symmetry (as there is for the autocorrelation) forcing the Fourier transform to be real-valued. See Ultrashort pulse#Spectral phase, phase noise, group delay.

- Sometimes one encounters an amplitude spectral density (ASD), which is the square root of the PSD; the ASD of a voltage signal has units of V Hz−1/2.[20] This is useful when the shape of the spectrum is rather constant, since variations in the ASD will then be proportional to variations in the signal’s voltage level itself. But it is mathematically preferred to use the PSD, since only in that case is the area under the curve meaningful in terms of actual power over all frequency or over a specified bandwidth.

Applications[edit]

Any signal that can be represented as a variable that varies in time has a corresponding frequency spectrum. This includes familiar entities such as visible light (perceived as color), musical notes (perceived as pitch), radio/TV (specified by their frequency, or sometimes wavelength) and even the regular rotation of the earth. When these signals are viewed in the form of a frequency spectrum, certain aspects of the received signals or the underlying processes producing them are revealed. In some cases the frequency spectrum may include a distinct peak corresponding to a sine wave component. And additionally there may be peaks corresponding to harmonics of a fundamental peak, indicating a periodic signal which is not simply sinusoidal. Or a continuous spectrum may show narrow frequency intervals which are strongly enhanced corresponding to resonances, or frequency intervals containing almost zero power as would be produced by a notch filter.

Electrical engineering[edit]

Spectrogram of an FM radio signal with frequency on the horizontal axis and time increasing upwards on the vertical axis.

The concept and use of the power spectrum of a signal is fundamental in electrical engineering, especially in electronic communication systems, including radio communications, radars, and related systems, plus passive remote sensing technology. Electronic instruments called spectrum analyzers are used to observe and measure the power spectra of signals.

The spectrum analyzer measures the magnitude of the short-time Fourier transform (STFT) of an input signal. If the signal being analyzed can be considered a stationary process, the STFT is a good smoothed estimate of its power spectral density.

Cosmology[edit]

Primordial fluctuations, density variations in the early universe, are quantified by a power spectrum which gives the power of the variations as a function of spatial scale.

Climate Science[edit]

Power spectral-analysis have been used to examine the spatial structures for climate research.[21] These results suggests atmospheric turbulence link climate change to more local regional volatility in weather conditions.[22]

See also[edit]

- Bispectrum

- Brightness temperature

- Colors of noise

- Least-squares spectral analysis

- Noise spectral density

- Spectral density estimation

- Spectral efficiency

- Spectral leakage

- Spectral power distribution

- Whittle likelihood

- Window function

Notes[edit]

References[edit]

- ^ a b c P Stoica & R Moses (2005). «Spectral Analysis of Signals» (PDF).

- ^ Gérard Maral (2003). VSAT Networks. John Wiley and Sons. ISBN 978-0-470-86684-9.

- ^ Michael Peter Norton & Denis G. Karczub (2003). Fundamentals of Noise and Vibration Analysis for Engineers. Cambridge University Press. ISBN 978-0-521-49913-2.

- ^ Alessandro Birolini (2007). Reliability Engineering. Springer. p. 83. ISBN 978-3-540-49388-4.

- ^ Oppenheim; Verghese. Signals, Systems, and Inference. pp. 32–4.

- ^ a b Stein, Jonathan Y. (2000). Digital Signal Processing: A Computer Science Perspective. Wiley. p. 115.

- ^ Hannes Risken (1996). The Fokker–Planck Equation: Methods of Solution and Applications (2nd ed.). Springer. p. 30. ISBN 9783540615309.

- ^ Fred Rieke; William Bialek & David Warland (1999). Spikes: Exploring the Neural Code (Computational Neuroscience). MIT Press. ISBN 978-0262681087.

- ^ Scott Millers & Donald Childers (2012). Probability and random processes. Academic Press. pp. 370–5.

- ^ The Wiener–Khinchin theorem makes sense of this formula for any wide-sense stationary process under weaker hypotheses:

does not need to be absolutely integrable, it only needs to exist. But the integral can no longer be interpreted as usual. The formula also makes sense if interpreted as involving distributions (in the sense of Laurent Schwartz, not in the sense of a statistical Cumulative distribution function) instead of functions. If

is continuous, Bochner’s theorem can be used to prove that its Fourier transform exists as a positive measure, whose distribution function is F (but not necessarily as a function and not necessarily possessing a probability density).

- ^ Dennis Ward Ricker (2003). Echo Signal Processing. Springer. ISBN 978-1-4020-7395-3.

- ^ Robert Grover Brown & Patrick Y.C. Hwang (1997). Introduction to Random Signals and Applied Kalman Filtering. John Wiley & Sons. ISBN 978-0-471-12839-7.

- ^ Von Storch, H.; Zwiers, F. W. (2001). Statistical analysis in climate research. Cambridge University Press. ISBN 978-0-521-01230-0.

- ^ An Introduction to the Theory of Random Signals and Noise, Wilbur B. Davenport and Willian L. Root, IEEE Press, New York, 1987, ISBN 0-87942-235-1

- ^ William D Penny (2009). «Signal Processing Course, chapter 7».

- ^ Iranmanesh, Saam; Rodriguez-Villegas, Esther (2017). «An Ultralow-Power Sleep Spindle Detection System on Chip». IEEE Transactions on Biomedical Circuits and Systems. 11 (4): 858–866. doi:10.1109/TBCAS.2017.2690908. hdl:10044/1/46059. PMID 28541914. S2CID 206608057.

- ^ Imtiaz, Syed Anas; Rodriguez-Villegas, Esther (2014). «A Low Computational Cost Algorithm for REM Sleep Detection Using Single Channel EEG». Annals of Biomedical Engineering. 42 (11): 2344–59. doi:10.1007/s10439-014-1085-6. PMC 4204008. PMID 25113231.

- ^ Drummond JC, Brann CA, Perkins DE, Wolfe DE: «A comparison of median frequency, spectral edge frequency, a frequency band power ratio, total power, and dominance shift in the determination of depth of anesthesia,» Acta Anaesthesiol. Scand. 1991 Nov;35(8):693-9.

- ^ Swartz, Diemo (1998). «Spectral Envelopes». [1].

- ^ Michael Cerna & Audrey F. Harvey (2000). «The Fundamentals of FFT-Based Signal Analysis and Measurement» (PDF).

- ^ Communication, N. B. I. (2022-05-23). «Danish astrophysics student discovers link between global warming and locally unstable weather». nbi.ku.dk. Retrieved 2022-07-23.

- ^ Sneppen, Albert (2022-05-05). «The power spectrum of climate change». The European Physical Journal Plus. 137 (5): 555. arXiv:2205.07908. Bibcode:2022EPJP..137..555S. doi:10.1140/epjp/s13360-022-02773-w. ISSN 2190-5444. S2CID 248652864.

External links[edit]

- Power Spectral Density Matlab scripts

1.3.1. Спектральная плотность энергии

1.3.2. Спектральная плотность мощности

Спектральная плотность (spectral density) характеристик сигнала — это распределение энергии или мощности сигнала по диапазону частот. Особую важность это понятие приобретает при рассмотрении фильтрации в системах связи. Мы должны иметь возможность оценить сигнал и шум на выходе фильтра. При проведении подобной оценки используется спектральная плотность энергии (energy spectral density — ESD) или спектральная плотность мощности (power spectral density — PSD).

1.3.1. Спектральная плотность энергии

Общая энергия действительного энергетического сигнала , определенного в интервале

описывается уравнением (1.7). Используя теорему Парсеваля [1], мы можем связать энергию такого сигнала, выраженную во временной области, с энергией, выраженной в частотной области:

где — Фурье-образ непериодического сигнала

. (Краткие сведения об анализе Фурье можно найти в приложении А.) Обозначим через

прямоугольный амплитудный спектр, определенный как

(1.14)

Величина является спектральной плотностью энергии (ESD) сигнала

. Следовательно, из уравнения (1.13) можно выразить общую энергию

путем интегрирования спектральной плотности по частоте.

Данное уравнение показывает, что энергия сигнала равна площади под на графике в частотной области. Спектральная плотность энергии описывает энергию сигнала на единицу ширины полосы и измеряется в Дж/Гц. Положительные и отрицательные частотные компоненты дают равные энергетические вклады, поэтому, для реального сигнала

, величина

представляет собой четную функцию частоты. Следовательно, спектральная плотность энергии симметрична по частоте относительно начала координат, а общую энергию сигнала

можно выразить следующим образом.

1.3.2. Спектральная плотность мощности

Средняя мощность действительного сигнала в периодическом представлении

определяется уравнением (1.8). Если

— это периодический сигнал с периодом

, он классифицируется как сигнал в периодическом представлении. Выражение для средней мощности периодического сигнала дается формулой (1.6), где среднее по времени берется за один период

.

Теорема Парсеваля для действительного периодического сигнала [1] имеет вид

где члены являются комплексными коэффициентами ряда Фурье для периодического сигнала (см. приложение А).

Чтобы использовать уравнение (1.17,6), необходимо знать только значение коэффициентов . Спектральная плотность мощности (PSD)

периодического сигнала

, которая является действительной, четной и неотрицательной функцией частоты и дает распределение мощности сигнала

по диапазону частот, определяется следующим образом.

(1.18)

Уравнение (1.18) определяет спектральную плотность мощности периодического сигнала как последовательность взвешенных дельта-функций. Следовательно, PSD периодического сигнала является дискретной функцией частоты. Используя PSD, определенную в уравнении (1.18), можно записать среднюю нормированную мощность действительного сигнала.

Уравнение (1.18) описывает PSD только периодических сигналов. Если — непериодический сигнал, он не может быть выражен через ряд Фурье; если он является непериодическим сигналом в периодическом представлении (имеющим бесконечную энергию), он может не иметь Фурье-образа. Впрочем, мы по-прежнему можем выразить спектральную плотность мощности таких сигналов в пределе. Если сформировать усеченную версию

непериодического сигнала в периодическом представлении

, взяв для этого только его значения из интервала (

), то

будет иметь конечную энергию и соответствующий Фурье-образ

. Можно показать [2], что спектральная плотность мощности непериодического сигнала

определяется как предел.

(1.20)

Пример 1.1. Средняя нормированная мощность

а) Найдите среднюю нормированную мощность сигнала , используя усреднение по времени.

б) Выполните п. а путем суммирования спектральных коэффициентов.

Решение

а) Используя уравнение (1.17,а), имеем следующее.

б) Используя уравнения (1.18) и (1.19), получаем следующее.

Наиболее важной

характеристикой стационарных случайных

процессов является спектральная

плотность мощности, описывающая

распределение мощности шума по частотному

спектру. Рассмотрим

стационарный случайный процесс, который

может быть представлен беспорядочной

последовательностью импульсов напряжения

или тока, следующих друг за другом через

случайные интервалы времени. Процесс

со случайной последовательностью

импульсов является непериодическим.

Тем не менее, можно говорить о спектре

такого процесса, понимая в данном случае

под спектром распределение мощности

по частотам.

Для

описания шумов вводят понятие спектральной

плотности мощности (СПМ) шума, называемой

также в общем случае спектральной

плотностью (СП) шума,которая

определяется соотношением:

(2.10)

где P(f)

— усредненная по времени мощность шума

в полосе частотfна частоте измеренияf.

Как

следует из соотношения (2.10), СП шума

имеет размерность Вт/Гц. В общем случае

СП является функцией частоты. Зависимость

СП шума от частоты называют энергетическим

спектром,

который

несет информацию о динамических

характеристиках системы.

Если

случайный процесс эргодический, то

можно находить

энергетический спектр такого процесса

по его единственной реализации, что

широко используется на практике..

При рассмотрении

спектральных характеристик стационарного

случайного процесса часто оказывается

необходимым пользоваться понятием

ширины спектра шума. Площадь под кривой

энергетического спектра случайного

процесса, отнесенную к СП шума на

некоторой характерной частоте f0,

называютэффективной шириной спектра,

которая определяется по формуле:

(2.11)

Эту

величину можно трактовать как ширину

равномерного энергетического спектра

случайного процесса в полосе,

эквивалентного по средней мощности

рассматриваемому процессу.

Мощность шума P,

заключенная в полосе частотf1…f2, равна

Если СП шума в

полосе частот f1…f2постоянна и равнаS0, тогда для

мощности шума в данной полосе частот

имеем:гдеf =f2—f1– полоса частот, пропускаемая

схемой или измерительным прибором.

Важным случаем

стационарного случайного процесса

является белый шум, для которого

спектральная плотность не зависит от

частоты в широком диапазоне частот

(теоретически – в бесконечном диапазоне

частот). Энергетический спектр белого

шума в диапазоне частот -∞ < f

< +∞ дается выражением:

= 2S0

= const,

(2.13)

Модель белого шума

описывает случайный процесс без памяти

(без последействия). Белый

шумвозникает в системах с большим

числом простых однородных элементов и

характеризуется распределением амплитуды

флуктуаций по нормальному закону.

Свойства белого шума определяются

статистикой независимых одиночных

событий (например, тепловым движением

носителей заряда в проводнике или

полупроводнике). Вместе с тем истинный

белый шум с бесконечной полосой частот

не существует, поскольку он имеет

бесконечную мощность.

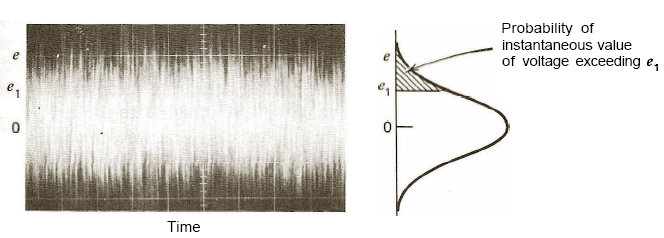

На рис. 2.3. приведена

типичная осциллограмма белого шума

(зависимость мгновенных значений

напряжения от времени) (рис. 2.3а) и функция

распределения вероятности мгновенных

величин напряжения e,которая является нормальным распределением

(рис. 2.3б). Заштрихованная площадь под

кривой соответствует вероятности

появления мгновенных величин напряженияe,

превышающих значениеe1.

а)

б)

Рис. 2.3. Типичная

осциллограмма белого шума (а) и функция

распределения плотности вероятности

мгновенных величин амплитуды напряжения

шума (б).

На практике при

оценке величины шума какого-либо элемента

или п/п прибора обычно измеряют

среднеквадратичное шумовое напряжение

в единицах В2или среднеквадратичный

токв единицах А2. При этом СП шума

выражают в единицах В2/Гц или

А2/Гц, а спектральные плотности

флуктуаций напряженияSu (f)

или токаSI (f)

вычисляются по следующим формулам:

(2.14)

где

и

– усредненные по времени шумовое

напряжение и ток в полосе частотfсоответственно. Черта сверху означает

усреднение по времени.

В практических

задачах при рассмотрении флуктуаций

различных физических величин вводят

понятие обобщенной спектральной

плотности флуктуаций. При этом СП

флуктуаций, например, для сопротивления

Rвыражается в единицах Ом2/Гц;

флуктуации магнитной индукции измеряются

в единицах Тл2/Гц, а флуктуации

частоты автогенератора – в единицах

Гц2/Гц = Гц.

При сравнении

уровней шума в линейных двухполюсниках

одного и того же типа удобно пользоваться

относительной спектральной плотностью

шума, которая определяется как

=

,

(2.15)

где u– падение

постоянного напряжения на линейном

двухполюснике.

Как видно из

выражения (2.15), относительная спектральная

плотность шума S(f)

выражается в единицах Гц-1.

Автокорреляционная функция и спектральная плотность мощности

Автокорреляционные функции детерминированного сигнала x(t) конечной длительности, периодического сигнала и случайного сигнала определяются как (1), (2), (3) соответственно:

Автокорреляционная функция периодического и случайного сигнала имеет размерность мощности, сигнала конечной длительности – размерность энергии. Автокорреляционная функция характеризует степень взаимосвязи предыдущих и последующих значений сигнала. При τ=0 она максимальна.

Функция (4) взаимной корреляции двух разных сигналов x(t), y(t) конечной длительности характеризует степень взаимосвязи этих сигналов. Величину (5) называют интервалом корреляции. Значения сигналов, отстоящие друг от друга на интервал времени больше τk, являются практически взаимно независимыми

Корреляционные функции вычисляют для центрированных величин. Аналогичные функции, определенные для не центрированных величин, называются ковариационными.

Рекомендуемые материалы

Пример: автокорреляционная функция прямоугольного импульса

Спектральный состав случайного сигнала описывают спектральной плотностью мощности Р(ω). На ограниченном интервале времени Т энергия Е и средняя мощность Р конкретной реализации случайного процесса

где S(ω) — спектральная плотность, а │S(ω)│2/T — спектральная плотность мощности данной реализации случайного процесса, т.е. средняя за интервал Т мощность в полосе частот 1 Гц. Чтобы найти спектральную плотность мощности всего процесса, а не одной реализации, необходимо усреднение по ансамблю, а при эргодическом случайном процессе – усреднение по времени. Удобнее вычислять

спектральную плотность мощности через корреляционную функцию.

Согласно теореме Винера – Хинчина (1934 г.), спектральная плотность мощности и корреляционная функция связаны между собой преобразованием Фурье

Лекция «50 Правовой режим уставного капитала» также может быть Вам полезна.

Функции R(τ), Р(ω) четные, поэтому интегрирование можно вести только в области ω>0:

Аналогичным соотношением связаны энергетический спектр и автокорреляционная функция непериодического детерминированного сигнала:

Чем шире спектр сигнала (сильнее представлены высокочастотные составляющие сигнала), тем слабее взаимосвязь предыдущих и последующих значений сигнала и уже корреляционная функция.

![{displaystyle left|{hat {x}}_{T}(f)right|^{2}={mathcal {F}}left{x_{T}^{*}(-t)mathbin {mathbf {*} } x_{T}(t)right}=int _{-infty }^{infty }left[int _{-infty }^{infty }x_{T}^{*}(t-tau )x_{T}(t)dtright]e^{-i2pi ftau } dtau }](https://wikimedia.org/api/rest_v1/media/math/render/svg/bd30e832ba7df7f30cdbd74043c8209d661f4b30)

![{displaystyle lim _{Tto infty }{frac {1}{T}}left|{hat {x}}_{T}(f)right|^{2}=int _{-infty }^{infty }left[lim _{Tto infty }{frac {1}{T}}int _{-infty }^{infty }x_{T}^{*}(t-tau )x_{T}(t)dtright]e^{-i2pi ftau } dtau =int _{-infty }^{infty }R_{xx}(tau )e^{-i2pi ftau }dtau }](https://wikimedia.org/api/rest_v1/media/math/render/svg/62dc3089e7eba0d870dee75bc70ed54243cb0dba)

![{displaystyle {begin{aligned}P&=lim _{Tto infty }{frac {1}{T}}int _{-infty }^{infty }left[x_{T}(t)+y_{T}(t)right]^{*}left[x_{T}(t)+y_{T}(t)right]dt\&=lim _{Tto infty }{frac {1}{T}}int _{-infty }^{infty }|x_{T}(t)|^{2}+x_{T}^{*}(t)y_{T}(t)+y_{T}^{*}(t)x_{T}(t)+|y_{T}(t)|^{2}dt\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0714e881bda14334fc847bdb3a20dc25c7d77b3d)

![{displaystyle {begin{aligned}S_{xy}(f)&=lim _{Tto infty }{frac {1}{T}}left[{hat {x}}_{T}^{*}(f){hat {y}}_{T}(f)right]&S_{yx}(f)&=lim _{Tto infty }{frac {1}{T}}left[{hat {y}}_{T}^{*}(f){hat {x}}_{T}(f)right]end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2e03b6cd665eb568fa3d4ecbaba1eb4a88e20b61)

![{displaystyle {begin{aligned}S_{xy}(f)&=int _{-infty }^{infty }left[lim _{Tto infty }{frac {1}{T}}int _{-infty }^{infty }x_{T}^{*}(t-tau )y_{T}(t)dtright]e^{-i2pi ftau }dtau =int _{-infty }^{infty }R_{xy}(tau )e^{-i2pi ftau }dtau \S_{yx}(f)&=int _{-infty }^{infty }left[lim _{Tto infty }{frac {1}{T}}int _{-infty }^{infty }y_{T}^{*}(t-tau )x_{T}(t)dtright]e^{-i2pi ftau }dtau =int _{-infty }^{infty }R_{yx}(tau )e^{-i2pi ftau }dtau end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4b1244b4ecf27604626c402b8e7b35bd59afa266)