Добавил:

Upload

Опубликованный материал нарушает ваши авторские права? Сообщите нам.

Вуз:

Предмет:

Файл:

Книга_МО.pdf

Скачиваний:

457

Добавлен:

05.06.2015

Размер:

12.36 Mб

Скачать

|

□ Выпишем квадратичную форму |

xT H (x) x = ( |

x , |

x |

2 |

0 |

x |

= 2 |

x2 . |

|||||||||

|

2 |

) |

1 |

|||||||||||||||

|

1 |

0 |

x2 |

1 |

||||||||||||||

|

0 |

|||||||||||||||||

|

Очевидно, |

xT H (x) x ≥ 0 для любого вектора |

x |

и |

xT H (x) |

x = 0 |

для |

x = 0 и |

||||||||||

|

1 |

|||||||||||||||||

|

любых |

x2 ≠ 0 . |

Согласно определению, |

квадратичная |

форма |

(матрица |

Гессе) |

|||||||||||

|

положительно полуопределенная. ■ |

|||||||||||||||||

|

Пример 4.6. Найти матрицу Гессе функции |

f (x) = x2 |

− x2 |

и классифицировать |

||||||||||||||

|

1 |

2 |

||||||||||||||||

|

ее. |

|||||||||||||||||

|

□ Следуя определению матрицы Гессе, получаем |

2 |

0 |

. Выпишем |

||||||||||||||

|

H (x) = |

|||||||||||||||||

|

− 2 |

|||||||||||||||||

|

0 |

|||||||||||||||||

|

соответствующую ей квадратичную форму |

|||||||||||||||||

|

xT H (x) x = ( x , x |

2 |

0 |

x |

= 2 x2 |

− 2 x2 . |

||||||||||||

|

2 |

) |

1 |

|||||||||||||||

|

1 |

1 |

2 |

|||||||||||||||

|

0 |

− 2 |

x2 |

|||||||||||||||

|

При |

x1 = 0 и любых x2 ≠ 0 квадратичная форма отрицательна, а при |

x1 ≠ 0 и |

x2 = 0 положительна. Квадратичная форма (матрица Гессе) неопределенная. ■

Решение задач минимизации в En , как правило, сопряжено со значительными трудностями, особенно для многоэкстремальных функций. Некоторые из этих трудностей устраняются, если ограничиться рассмотрением только выпуклых

|

целевых функций. |

|||||

|

Определение. |

Пусть |

x, y En . Множество точек |

вида |

{z} En , |

|

|

z =α x + (1 −α) y , |

α [0,1] называется отрезком, соединяющим точки x и y . |

||||

|

В пространстве En , |

n ≤ 3 это |

соотношение определяет |

обычный |

отрезок, |

|

|

соединяющий точки x и y . |

|||||

|

Определение. Множество U En |

называется выпуклым, если вместе с любыми |

||||

|

точками x и y U |

оно содержит и весь отрезок z =α x + (1 −α) y , |

α [0,1] . |

Необходимо отметить, что проверка условия выпуклости в большинстве случаев требует громоздких выкладок, поэтому на практике при исследовании выпуклости множества в пространствах E2 и E3 часто прибегают к решениям в графическом виде.

Образно говоря, выпуклыми являются множества, которые не содержат «вмятин», «дырок», и состоят из одного «куска». Примерами выпуклых множеств

60

|

являются само пространство En , отрезок, прямая, шар. Множество x2 |

+ y 2 |

=1 в E2 |

|||||||||||||||

|

не является выпуклым. |

|||||||||||||||||

|

Определение. |

Функция f (x) , заданная на |

выпуклом множестве |

U En , |

||||||||||||||

|

называется: |

|||||||||||||||||

|

− выпуклой, если |

для любых точек |

x, y U |

и |

любого |

α [0,1] |

выполняется |

|||||||||||

|

неравенство |

|||||||||||||||||

|

f (α x + (1 −α) y) ≤α f (x) + (1 −α) f ( y) . |

(4.3) |

||||||||||||||||

|

− строго выпуклой, если для всех α (0,1) неравенство |

(4.3) |

выполняется как |

|||||||||||||||

|

строгое |

|||||||||||||||||

|

f (α x + (1 −α) y) <α f (x) + (1 −α) f ( y) . |

(4.4) |

||||||||||||||||

|

− сильно выпуклой, с константой l > 0 , |

если для любых точек |

x, y U и любого |

|||||||||||||||

|

α [0,1] выполняется неравенство |

|||||||||||||||||

|

f (α x + (1 −α) y) ≤α f (x) + (1 −α) f ( y) − |

l |

α (1 −α) |

x − y |

2 . |

(4.5) |

||||||||||||

|

2 |

|||||||||||||||||

Необходимо обратить внимание на следующее.

1. Функцию f (x) называют выпуклой, если ее график целиком лежит не выше отрезка, соединяющего две ее произвольные точки. Функцию называют строго выпуклой, если ее график целиком лежит ниже отрезка, соединяющего две ее произвольные, но не совпадающие точки.

2.Если функция сильно выпуклая, то она одновременно строго выпуклая и выпуклая. Если функция строго выпуклая, то она одновременно выпуклая.

3.Выпуклость функции можно определить по матрице Гессе:

|

− если H (x) ≥ 0 |

для любого x En , то функция выпуклая, |

|

− если H (x) > 0 |

для любого x En , то функция строго выпуклая, |

|

− если H (x) ≥ l E для любого x En , где E − единичная матрица, то функция |

сильно выпуклая.

Пример 4.7. Исследовать на выпуклость функцию f (x) = x2 , определенную на множестве U ={x [−1, 1]}.

□ Функция является строго выпуклой, так как ее график целиком лежит ниже отрезка, соединяющего две ее произвольные, но не совпадающие точки. Более

|

того, функция |

является сильно выпуклой, так как выполняется условие |

|

|

′′ |

≥l |

при 0 < l ≤ 2 . ■ |

|

H (x) = f (x) = 2 |

61

Пример 4.8. Исследовать на выпуклость функцию f (x) = x , определенную на множестве U ={x [0, 1]}.

□ Функция является выпуклой, так как ее график целиком лежит не выше отрезка, соединяющего две ее произвольные точки, но не является строго

|

выпуклой и тем более сильно выпуклой. ■ |

||||||||

|

Пример 4.9. Исследовать на выпуклость функцию |

f (x) = x2 |

+ x2 |

, определенную |

|||||

|

1 |

2 |

|||||||

|

на множестве E2 . |

||||||||

|

□ Матрица Гессе функции удовлетворяет условию H (x) = |

2 |

0 |

1 |

0 |

при |

|||

|

≥ l |

||||||||

|

1 |

||||||||

|

0 |

2 |

0 |

0 < l ≤ 2 . Следовательно, эта функция сильно выпукла. Одновременно она является строго выпуклой и выпуклой. ■

В дальнейшем часто используются следующие свойства выпуклых функций. 1. Если f (x) выпуклая функция на выпуклом множестве U , то всякая точка

локального минимума является точкой ее глобального минимума на U .

2.Если выпуклая функция достигает своего минимума в двух различных точках, то она достигает минимума во всех точках отрезка, соединяющего эти точки.

3.Если f (x) строго выпуклая функция на выпуклом множестве U , то она

может достигать своего глобального минимума на U не более чем в одной точке.

4.3. Необходимые и достаточные условия безусловного экстремума

Необходимые условия экстремума первого порядка. Пусть x En есть точка

|

локального минимума (максимума) |

функции f (x) |

на множестве |

En и f (x) |

|||||

|

дифференцируема в точке x . Тогда градиент функции |

f (x) в точке x равен нулю |

|||||||

|

) |

= |

0 , |

(4.6) |

|||||

|

или |

f (x |

|||||||

|

(4.7) |

||||||||

|

∂f (x |

) = 0, |

i =1, …, n . |

||||||

|

∂xi |

||||||||

|

Точки x , удовлетворяющие |

условию (4.6) |

или (4.7), |

называются |

|||||

|

стационарными. |

62

Необходимые условия экстремума второго порядка. Пусть x En есть точка

|

локального минимума (максимума) функции |

f (x) , определенной на множестве En |

|

|

и функция f (x) дважды |

дифференцируема |

в этой точке. Тогда матрица Гессе |

|

H (x ) функции f (x) , |

вычисленная в |

точке x , является положительно |

полуопределенной (отрицательно полуопределенной), т.е. H (x ) ≥ 0 , ( H (x ) ≤ 0 ).

Достаточные условия экстремума. Пусть функция f (x) в точке x En

дважды дифференцируема, ее градиент равен нулю, а матрица Гессе является положительно определенной (отрицательно определенной), т.е.

|

) |

= |

0 |

и |

H (x |

) |

> |

0 , ( H (x |

) |

< |

0 ). |

(4.8) |

||||

|

f (x |

|||||||||||||||

|

Тогда x − точка локального минимума (максимума) функции f (x) |

на En . |

Проверка выполнения условий экстремума. Рассмотрим матрицу Гессе,

составленную для стационарной точки x

|

h |

h |

… |

h |

|||

|

11 |

12 |

1n |

||||

|

H (x |

h21 |

h22 |

… |

h2n |

||

|

) = |

… |

… |

. |

|||

|

… … |

||||||

|

hn1 |

hn2 |

… |

hnn |

Угловыми минорами k -го порядка матрицы размера n ×n , где k ≤ n называются определители, составленные из элементов исходной матрицы, стоящих в ней на пересечении k верхних строк и k левых столбцов.

Главными минорами m —го порядка матрицы размера n ×n , где m ≤ n называются определители, составленные из элементов исходной матрицы, оставшихся после вычеркивания в ней любых (n − m) строк и (n − m) столбцов с одинаковыми номерами.

Существуют два основных способа проверки выполнения условий экстремума. Первый способ связан с исследованием положительной или отрицательной определенности угловых и главных миноров матрицы Гессе. Второй способ основан на анализе собственных значений этой матрицы.

В первом случае, при анализе знаков угловых и главных миноров матрицы Гессе, доказаны и обычно используются на практике два критерия − проверки достаточных и необходимых условий второго порядка. Приведем их без доказательства.

63

Критерий Сильвестра проверки достаточных условий экстремума

|

1. Для того, чтобы матрица Гессе |

H (x ) была положительно определенной |

|

( H (x ) > 0 ) и стационарная точка x |

являлась точкой локального минимума, |

необходимо и достаточно, чтобы знаки угловых миноров были строго положительны

|

( |

1 > 0, |

2 > 0, …, |

n > 0). |

|

2. Для того, чтобы матрица Гессе |

H (x ) |

была отрицательно определенной |

|

|

( H (x ) < 0 ) и стационарная |

точка |

x |

являлась точкой локального максимума, |

необходимо и достаточно, чтобы знаки угловых миноров чередовались, начиная с отрицательного

( 1 < 0, 2 > 0, 3 < 0, …, (−1)n n > 0).

Критерий проверки необходимых условий экстремума второго порядка

1. Для того, чтобы матрица Гессе H (x ) была положительно полуопределенной

( H (x ) ≥ 0 ) и стационарная точка x может быть являлась точкой локального

минимума, необходимо и достаточно, чтобы все главные миноры определителя матрицы Гессе были неотрицательны

( 1 ≥ 0, 2 ≥ 0, …, n ≥ 0).

2. Для того, чтобы матрица Гессе H (x ) была отрицательно полуопределенной

( H (x ) ≤ 0 ) и стационарная точка x может быть являлась точкой локального

максимума, необходимо и достаточно, чтобы все главные миноры четного порядка были неотрицательны, а все главные миноры нечетного порядка − неположительны

( 1 ≤ 0, 2 ≥ 0, 3 ≤ 0, …, (−1)n n ≥ 0).

Второй способ проверки условий экстремума связан с анализом собственных значений матрицы Гессе и применим только в случае, если эти значения удается вычислить.

|

Определение. |

Собственные |

значения λi , i =1, …, n |

матрицы |

H (x ) размера |

||||||

|

n ×n находятся |

как корни |

характеристического уравнения (алгебраического |

||||||||

|

уравнения n — й степени) |

H (x ) − λE |

= 0 . |

||||||||

|

Необходимо |

отметить, |

что |

собственные |

значения |

вещественной |

|||||

|

симметрической матрицы H (x ) |

вещественны. |

64

Если собственные значения матрицы Гессе вычислены, то дальнейшая проверка условий экстремума не составляет затруднений. Приведем в виде таблицы порядок применения двух способов, позволяющих установить достаточные условия экстремума и необходимые условия второго порядка при соблюдении необходимых условий первого порядка f (x ) = 0 (табл. 4.1).

Критерии проверки достаточных и необходимых условий второго порядка при поиске безусловного экстремума. Таблица 4.1.

|

№ |

H (x ) |

Условия |

Первый способ |

|||

|

1 |

> 0 |

Достаточные |

1 |

> 0, |

2 > 0,…, |

|

|

условия экстремума |

> 0 |

|||||

|

n |

||||||

|

2 |

< 0 |

Достаточные |

1 < 0, |

2 > 0, 3 < 0, …, |

||

|

условия экстремума |

(−1)n |

n |

> 0 |

|||

|

3 |

≥ 0 |

Необходимые условия |

Все главные миноры |

|||

|

экстремума второго |

определителя матрицы |

|||||

|

порядка |

H (x ) неотрицательны |

|||||

|

4 |

≤ 0 |

Необходимые условия |

Все главные миноры |

|||

|

экстремума второго |

четного порядка ≥ 0 , |

|||||

|

порядка |

нечетного порядка≤ 0 . |

|||||

|

5 |

= 0 |

Необходимые условия |

Матрица Гессе состоит |

|||

|

экстремума второго |

из нулевых элементов |

|||||

|

порядка |

||||||

|

6 |

> 0, < 0 |

Необходимые условия |

Не выполняются |

|||

|

экстремума второго |

условия 1-5. |

|||||

|

порядка |

||||||

|

Второй способ |

Тип |

|

|

стационарной |

||

|

точки x |

||

|

λ1 > 0,…, λn |

> 0 |

Локальный |

|

минимум |

||

|

λ1 < 0,…, λn |

< 0 |

|

|

Локальный |

||

|

максимум |

||

|

λ1 ≥ 0,…, λn |

≥ 0 |

|

|

Может быть |

||

|

локальный |

||

|

минимум, |

||

|

требуется |

||

|

дополнит. |

||

|

λ1 ≤ 0,…, λn |

≤ 0 |

исследование |

|

Может быть |

||

|

локальный |

||

|

максимум, |

||

|

требуется |

||

|

дополнит. |

||

|

исследование |

||

|

λ1 = 0,…, λn |

= 0 |

|

|

Требуется |

||

|

дополнит. |

||

|

исследование |

||

|

λi имеют разные |

Нет экстремума |

|

|

знаки |

||

Алгоритм решения задачи следующий.

Шаг 1. Записать необходимые условия экстремума первого порядка и найти стационарные точки x в результате решения системы n в общем случае нелинейных алгебраических уравнений с n неизвестными. Для численного решения системы могут использоваться методы простой итерации, Зейделя, Ньютона.

Шаг 2. В найденных стационарных точках x проверить выполнение достаточных условий, а если они не выполняются, то необходимых условий второго порядка с помощью одного из двух способов (табл. 4.1).

65

Шаг 3. Вычислить значения f (x ) в точках экстремума.

Необходимо обратить внимание на следующее.

1.Если требуется определить глобальные экстремумы, то они находятся в результате сравнения значений функции в точках локальных экстремумов с учетом ограниченности функции на En .

2.Для функции одной переменной f (x) можно воспользоваться следующим правилом, заменяющим операции на шаге 2.

|

Если f (x) и ее производные непрерывны, то |

точка x является точкой |

|

|

экстремума тогда и только тогда, |

когда m − четное, |

где m − порядок первой не |

|

обращающейся в нуль в точке x |

производной. Если |

f (m) (x ) > 0 , то в точке x − |

|

локальный минимум, а если f (m) (x ) < 0 , то в точке |

x − локальный максимум. |

|

|

Если число m нечетное, то в точке x нет экстремума. |

3. Часто на практике при применении численных методов поиска экстремума требуется проверить, выполняются ли необходимые и достаточные условия экстремума в некоторой точке. Такая проверка необходима, так как многие численные методы позволяют найти лишь стационарную точку, тип которой

|

требует уточнения. |

||||||||||||||||||||

|

Пример |

4.10. |

Найти экстремум функции |

f (x) = x2 |

+ x2 , |

определенной |

на |

||||||||||||||

|

1 |

2 |

|||||||||||||||||||

|

множестве E2 . |

||||||||||||||||||||

|

□ 1. Запишем необходимые условия экстремума первого порядка |

||||||||||||||||||||

|

∂f (x) |

= 2x = 0; |

∂f (x) |

= 2x |

2 |

= 0 . |

|||||||||||||||

|

1 |

∂x2 |

|||||||||||||||||||

|

∂x1 |

||||||||||||||||||||

|

В результате решения системы получаем стационарную точку x |

= (0, 0)T . |

|||||||||||||||||||

|

2. Проверим выполнение достаточных условий экстремума. |

||||||||||||||||||||

|

Первый |

способ. |

Матрица Гессе |

имеет |

2 |

0 |

как |

||||||||||||||

|

вид H (x ) = |

. Так |

|||||||||||||||||||

|

0 |

||||||||||||||||||||

|

2 |

||||||||||||||||||||

|

1 |

= h = 2 > 0, |

2 |

= |

2 |

0 |

= 4 > 0 , то в точке x локальный минимум (строка 1 табл. |

||||||||||||||

|

11 |

0 |

2 |

||||||||||||||||||

|

4.1). |

66

|

Второй способ. Найдем собственные значения матрицы Гессе |

2 − λ |

0 |

||||||

|

= 0 . |

||||||||

|

0 |

2 − λ |

|||||||

|

Отсюда |

(2 − λ)2 = 0, λ = λ |

2 |

= 2 > 0 . Так как все собственные |

значения |

||||

|

1 |

||||||||

|

положительны, то в точке |

x |

локальный минимум (строка 1 табл. 4.1). Так как |

H (x ) > 0 , то функция строго выпукла на множестве E2 . Поэтому точка локального минимума является и точкой глобального минимума.

|

3. Вычислим значение функции в точке глобального минимума f (x ) = 0 . ■ |

||||||||||||||||||||

|

Пример 4.11. Найти экстремум функции f (x) = x2 |

− x2 на множестве E |

2 |

. |

|||||||||||||||||

|

1 |

2 |

|||||||||||||||||||

|

□ 1. Запишем необходимые условия экстремума первого порядка |

||||||||||||||||||||

|

∂f (x) |

= 2x = 0; |

∂f (x) |

= −2x |

2 |

= 0 . |

|||||||||||||||

|

1 |

∂x2 |

|||||||||||||||||||

|

∂x1 |

||||||||||||||||||||

|

В результате решения системы получаем стационарную точку x = (0, |

0)T . |

|||||||||||||||||||

|

2. Проверим выполнение достаточных условий экстремума и необходимых |

||||||||||||||||||||

|

условий второго порядка. |

||||||||||||||||||||

|

Первый способ. |

Матрица Гессе |

имеет вид |

2 |

0 |

Так |

как |

||||||||||||||

|

H (x ) = |

. |

|||||||||||||||||||

|

0 |

− 2 |

|||||||||||||||||||

|

1 |

= h = 2 > 0, |

2 |

= |

2 |

0 |

= −4 < 0 , то |

достаточные условия |

экстремума |

не |

|||||||||||

|

11 |

0 |

− 2 |

||||||||||||||||||

выполняются (строки 1 и 2 табл. 4.1). Проверим выполнение необходимых условий

|

второго порядка. Главные миноры первого порядка |

(m =1) получаются из 2 в |

|||

|

результате |

вычеркивания |

n − m = 2 −1 =1 строк |

и |

столбцов с одинаковыми |

|

номерами, |

а их значения равны соответственно −2 |

и |

2 . Главный минор второго |

|

|

порядка получается из |

2 |

в результате вычеркивания n − m = 0 строк и столбцов и |

||

|

совпадает |

с 2 = −4 . |

Отсюда следует, что необходимые условия экстремума |

второго порядка не выполняются (строки 3 и 4 в табл. 4.1). Так как матрица Гессе не является нулевой, то делаем вывод, что в точке x экстремума нет (строка 6 в

табл. 4.1).

|

Второй способ. Найдем собственные значения матрицы Гессе: |

2 − |

λ |

0 |

||

|

= 0 . |

|||||

|

0 |

− 2 − λ |

Отсюда (2 − λ)(−2 − λ) = 0, λ1 = −2 < 0, λ2 = 2 > 0 , т.е. собственные значения имеют

67

разные знаки. Поэтому точка x не является точкой минимума или максимума (строка 6 в табл. 4.1).

3. Так как экстремума нет ни в одной точке, значение f (x ) не вычисляется. ■

|

Пример 4.12. Найти экстремум функции |

f (x) = x2 |

+ x4 |

, определенной на |

|

1 |

2 |

множестве E2 .

□ 1. Запишем необходимые условия экстремума первого порядка

|

∂f (x) = 2x = 0; |

∂f (x) = 4x3 |

= 0 . |

|

1 |

2 |

|

|

∂x1 |

∂x2 |

Врезультате решения системы получаем стационарную точку x = (0, 0)T .

2.Проверим выполнение достаточных условий второго порядка. Матрица Гессе

|

имеет вид |

2 |

0 |

2 |

0 |

. Так как |

= h = 2 > 0, |

= |

2 |

0 |

= 0 |

, то |

||||||||

|

H (x ) = |

2 |

= |

1 |

2 |

|||||||||||||||

|

0 |

12x |

0 |

0 |

11 |

0 |

0 |

|||||||||||||

|

2 |

достаточные условия экстремума не выполняются. Проверим выполнение необходимых условий экстремума второго порядка. Аналогично решению предыдущего примера получаем значения главных миноров первого порядка, соответственно 2 и 0 и главный минор второго порядка 0. Так как все главные

|

миноры неотрицательные, то в |

точке x |

может быть |

минимум |

и |

требуется |

||||||||||||||||

|

дополнительное исследование. |

|||||||||||||||||||||

|

3. Вычислим значение целевой функции в стационарной точке |

f (x ) = 0 |

и |

|||||||||||||||||||

|

рассмотрим ε -окрестность точки x , а также поведение |

функции |

f (x) |

на |

||||||||||||||||||

|

множестве E2 . При |

любых x E2 имеем |

f (x) ≥ f (x ) = 0 . |

Поэтому |

точка |

x |

||||||||||||||||

|

является точкой глобального минимума. ■ |

|||||||||||||||||||||

|

Пример 4.13. Найти экстремум функции |

f (x) = −x2 − x |

2 − x2 |

− x + x x |

2 |

+ 2x |

3 |

на |

||||||||||||||

|

1 |

2 |

3 |

1 |

1 |

|||||||||||||||||

|

E3 . |

|||||||||||||||||||||

|

□ 1. Запишем необходимые условия экстремума первого порядка |

|||||||||||||||||||||

|

∂f (x) |

= −2x −1 + x |

2 |

= 0, |

∂f (x) |

= −2x |

2 |

+ x = 0, |

∂f (x) |

= −2x |

3 |

+ 2 = 0 . |

||||||||||

|

1 |

∂x2 |

1 |

∂x3 |

||||||||||||||||||

|

∂x1 |

|||||||||||||||||||||

|

В |

результате |

решения |

системы |

получаем |

стационарную |

точку |

|||||||||||||||

|

x = (− 2 |

, − 1 , 1)T . |

||||||||||||||||||||

|

3 |

3 |

2. Проверим выполнение достаточных условий экстремума.

68

|

− 2 |

1 |

0 |

||||

|

Первый способ. Матрица Гессе имеет вид |

1 |

− 2 |

0 |

. Так как |

||

|

H (x ) = |

||||||

|

0 |

0 |

− 2 |

||||

|

1 = −2 < 0, 2 |

= |

− 2 |

1 |

= 4 −1 =3 > 0, |

3 |

= (−2) 3 = −6 < 0 |

, |

т.е. |

знаки |

угловых |

||||||||||||||||||||||||

|

1 |

− 2 |

|||||||||||||||||||||||||||||||||

|

миноров чередуются, начиная с отрицательного, то |

x |

− |

точка |

локального |

||||||||||||||||||||||||||||||

|

максимума. |

||||||||||||||||||||||||||||||||||

|

Второй способ. Найдем собственные значения матрицы Гессе |

||||||||||||||||||||||||||||||||||

|

det (H − λE) = |

− 2 − λ |

1 |

0 |

= 0 . |

||||||||||||||||||||||||||||||

|

1 |

− 2 − λ |

0 |

||||||||||||||||||||||||||||||||

|

Отсюда (−2 − λ)[(− 2 − λ)2 |

−1]= 0 |

0 |

0 |

− 2 − λ |

||||||||||||||||||||||||||||||

|

и λ1 = −2 < 0, |

λ2 = −1 < 0, |

λ3 = −3 < 0 . |

Так как все |

|||||||||||||||||||||||||||||||

|

собственные значения матрицы |

Гессе отрицательны, то в точке x локальный |

|||||||||||||||||||||||||||||||||

|

максимум. |

||||||||||||||||||||||||||||||||||

|

3. Вычислим значение функции в точке локального максимума |

f (x ) = |

4 |

. ■ |

|||||||||||||||||||||||||||||||

|

3 |

||||||||||||||||||||||||||||||||||

|

Пример 4.14. Найти экстремум функции f (x) = x3 |

+ x3 |

−3x x |

2 |

на E |

2 |

. |

||||||||||||||||||||||||||||

|

1 |

2 |

1 |

||||||||||||||||||||||||||||||||

|

□ 1. Запишем необходимые условия экстремума первого порядка |

||||||||||||||||||||||||||||||||||

|

∂f (x) = 3x2 −3x |

2 |

= 0; |

∂f (x) = 3x2 |

−3x = 0 . |

||||||||||||||||||||||||||||||

|

∂x1 |

1 |

∂x2 |

2 |

1 |

||||||||||||||||||||||||||||||

|

Решая систему, найдем стационарные точки x |

= (0, 0)T ; x = (1, 1)T . |

|||||||||||||||||||||||||||||||||

|

1 |

2 |

|||||||||||||||||||||||||||||||||

|

2. Проверим выполнение достаточных условий второго порядка. |

||||||||||||||||||||||||||||||||||

|

Первый способ. |

6x |

− |

3 |

0 |

−3 |

|||||||||||||||||||||||||||||

|

Матрица Гессе имеет вид H (x ) = |

1 |

= |

при |

|||||||||||||||||||||||||||||||

|

1 |

||||||||||||||||||||||||||||||||||

|

−3 6x2 |

−3 0 |

|||||||||||||||||||||||||||||||||

|

x = x . Так как |

= h = 0, |

= |

0 |

−3 |

= −9, |

то достаточные условия экстремума |

||||||||||||||||||||||||||||

|

1 |

1 |

11 |

2 |

−3 |

0 |

не выполняются. Проверим выполнение необходимых условий экстремума второго порядка. Главные миноры первого порядка равны 0, главный минор второго порядка равен -9. Необходимое условие второго порядка не выполняется,

|

следовательно, в точке |

x |

= (0, 0)T |

экстремума быть не может. |

В точке |

x |

= (1, 1)T |

|||||||

|

1 |

2 |

||||||||||||

|

матрица |

Гессе |

имеет |

вид |

6x |

−3 |

6 |

−3 |

Так |

как |

||||

|

H (x ) = |

1 |

= |

. |

||||||||||

|

2 |

−3 6x2 |

||||||||||||

|

−3 6 |

69

|

= h = 6 > 0, |

= |

6 |

−3 |

= 27 > 0, |

то выполняются достаточные |

условия, |

|||||||||||||

|

1 |

11 |

2 |

−3 |

6 |

|||||||||||||||

|

следовательно, |

x2 = (1, 1)T |

− точка локального минимума. |

|||||||||||||||||

|

Второй |

способ. |

Найдем |

собственные |

значения |

матрицы Гессе |

в точке |

|||||||||||||

|

x |

= (0, 0)T : |

det (H −λE) = |

−λ |

−3 |

= 0 , |

откуда |

λ = −3, λ |

2 |

= 3 . Так как собственные |

||||||||||

|

1 |

−3 |

−λ |

1 |

||||||||||||||||

значения имеют разные знаки, экстремума нет.

Найдем собственные значения матрицы Гессе в точке x2 = (1, 1)T :

|

det (H − λE) = |

6 − λ |

−3 |

= 0 , откуда λ = 3, λ |

2 |

= 9 . Так как все собственные |

||

|

−3 |

6 − λ |

1 |

|||||

значения положительны, следовательно, x2 = (1, 1)T − точка локального минимума.

|

3.Вычислим значение функции в точке локального максимума: |

f (x2 ) = −1 . ■ |

||||||||||||||||||||

|

Пример 4.15. Найти экстремум функции |

f (x) = 5x6 |

−36x5 + |

165 x4 −60x3 |

+36 |

на |

||||||||||||||||

|

2 |

|||||||||||||||||||||

|

E1 . |

|||||||||||||||||||||

|

□ 1. Выпишем необходимое условие экстремума первого порядка |

|||||||||||||||||||||

|

d f (x) |

= 30x5 |

−180x 4 |

+ 330x3 |

−180x 2 |

= 30x 2 (x −1)(x − 2)(x − 3) = 0. |

||||||||||||||||

|

d x |

|||||||||||||||||||||

|

Отсюда получаем стационарные точки x = 0, x =1, x = 2, x = 3. |

|||||||||||||||||||||

|

1 |

2 |

3 |

4 |

||||||||||||||||||

|

2. Проверим выполнение достаточных условий экстремума |

|||||||||||||||||||||

|

d 2 f (x) |

=150x4 |

− 720x3 |

+ 990x2 |

−360x , |

|||||||||||||||||

|

d x2 |

|||||||||||||||||||||

|

f ′′(x1 ) = 0, f ′′(x2 ) = 60 > 0, f ′′(x3 ) = −120 < 0, f ′′(x4 ) = 540 > 0 , |

|||||||||||||||||||||

|

поэтому в точках |

x2 , |

x4 − локальный минимум, а |

в точке x3 − локальный |

||||||||||||||||||

|

максимум. В точке |

x |

достаточные условия не выполняются, |

поэтому вычислим |

||||||||||||||||||

|

1 |

|||||||||||||||||||||

|

третью производную |

|||||||||||||||||||||

|

′′′ |

3 |

− 2160x |

2 |

+1980x −360 , |

f |

′′′ |

|||||||||||||||

|

f |

(x) = 600x |

(x1 ) = −360. |

|||||||||||||||||||

|

Так как эта производная отлична от нуля и имеет нечетный порядок, то в точке |

x |

||||||||||||||||||||

|

1 |

|||||||||||||||||||||

|

экстремума нет. |

|||||||||||||||||||||

|

3. Вычислим значения экстремумов функции f (1) = |

55 |

; f (2) = −108; f (3) = |

531 |

. ■ |

|||||||||||||||||

|

2 |

2 |

||||||||||||||||||||

70

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

27.03.201612.16 Mб29Клюшин Введение в дискретку.djvu

- #

- #

- #

- #

- #

- #

- #

Решение проблемы обнаружения центральной линии сосуда

Время на прочтение

9 мин

Количество просмотров 9K

Суть задачи

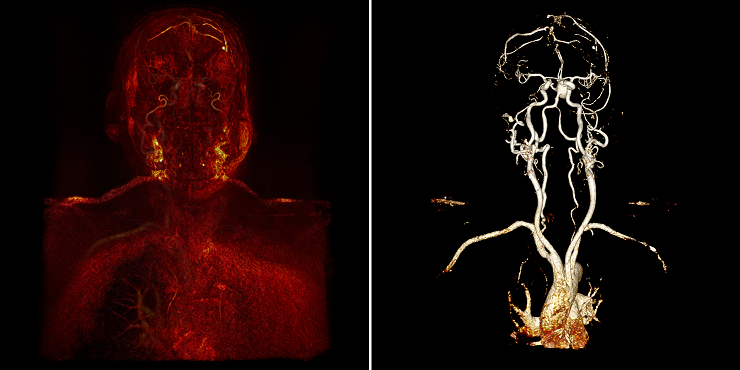

В процессе медицинской диагностики может возникнуть необходимость исследовать сосуды пациента. Такое исследование называется ангиографией. С появлением томографов в дополнение к классической ангиографии появились методы МРТ и КТ ангиографии, которые в отличие от традиционной ангиографии, дающей только плоскую картинку в одной проекции, позволяют получить полное трехмерное представление сосудов. Для проведения таких исследований пациенту в кровь вводится контраст — специальное вещество, делающее сосуды на снимках более яркими. В зависимости от предполагаемого диагноза, врач или оценивает общую картину, или пытается найти конкретные участки сосудов, в которых возникли проблемы. Если участок сосуда сужен и пропускает меньше крови, чем должен, то это место называется стенозом.

Одна из задач врача — найти стенозы и оценить, насколько они опасны. Задача же разработчика, как обычно, облегчить работу конечного пользователя. Для этого необходимо построить полную 3D модель стенок сосуда и провести их первичный анализ. Это является большой и интересной задачей, однако, в её основе лежит более простая и известная проблема — построение центральной линии сосуда.

Первая попытка

Перед продолжением чтения этой статьи желательно чуть-чуть ознакомиться с представлением данных, получаемых в результате работы томографов. Это можно сделать, прочитав нашу давно написанную статью про воксельный рендер DICOM Viewer изнутри. Если коротко: есть 3D-массив чисел, в каждом элементе которого хранится значение сигнала (интенсивность). Этот массив называется объемом. Сам элемент является вокселем, а его индексы в 3D-массиве будут являться 3D-координатами. Перед рендером каждого вокселя, его интенсивность обрабатывается функцией, и воксель приобретает определенные цвет, яркость и прозрачность.

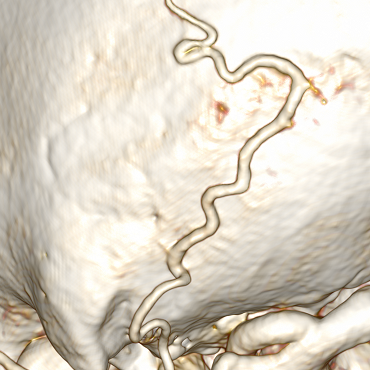

Относительно задачи, первое с чем столкнулся именно я — это то, что наш рендер позволяет уже на визуальном уровне показать все сосуды. А именно, из непонятной “каши”, как на рисунке слева, поигравшись с настройкам можно сделать вполне очевидные сосуды, как на рисунке справа:

Кажется, что задача решена: сосуды “вот они”, на ум сразу приходит region growing алгоритм: мы знаем цвет и прозрачность нужных нам вокселей, значит можно итерационно перебирать их соседей, пока не будет проложен путь между указанными точками.

Сегментируем сосуд

К тому же приходит идея, что если разобраться с ветвлениями, то можно вытянуть всю сеть сосудов. Но в действительности не всё так просто. Сосуд может вплотную прилегать к костям (их воксели идентичны по цветам, поэтому кость будет воспринята частью сосуда):

Пример

Сосуд может загибаться или прилегать вплотную к самому себе:

Пример

Участки сосуда могут быть очень тонкими и даже прерываться:

Пример

Нахождение оптимальных настроек рендера нетривиально. Пользователь может менять так называемое окно, и не существует конкретного значения окна, подходящего для всех сосудов хотя бы одного и того же исследования. Окно приходится каждый раз подгонять под конкретный случай. Ниже приведены три варианта одного и того же места с разными настройками:

В итоге приходим к тому, что интуитивно кажущийся верным алгоритм нужно либо дорабатывать, либо следует попробовать совершенно иной подход. После большого количества неудачных попыток пришлось пробовать что-то иное.

Классический подход

Основной подход к проблеме обнаружения сосудов (vessel detection), заключается в вычислении собственных значений матрицы Гессе (Hessian matrix). Также в последнее время к этой задаче пробуют подключить нейронные сети. Однако, стандартное решение выглядит более надежным, потому что имеет упоминание в большем количестве литературы и используется не только для нахождения сосудов, но и для многих других задач (например, обнаружение объектов на астрономических снимках), поэтому от нейронных сетей пришлось отказаться.

В нашем случае матрица Гессе — это матрица, элементами которой являются частные производные второго порядка интенсивности в конкретном вокселе:

— соответственно, вторые частные производные.

После построения матрицы Гессе необходимо найти её собственные значения и собственные векторы решив следующее уравнение:

— собственные значения. Задача их нахождения сводится к решению кубического уравнения, но в нашем случае матрица симметрична, поэтому решение упрощается и может быть представлено небольшим псевдокодом:

p1 = A(1,2)^2 + A(1,3)^2 + A(2,3)^2

if (p1 == 0)

eig1 = A(1,1)

eig2 = A(2,2)

eig3 = A(3,3)

else

q = trace(A)/3

p2 = (A(1,1) - q)^2 + (A(2,2) - q)^2 + (A(3,3) - q)^2 + 2 * p1

p = sqrt(p2 / 6)

B = (1 / p) * (A - q * I)

r = det(B) / 2

if (r <= -1)

phi = pi / 3

else if (r >= 1)

phi = 0

else

phi = acos(r) / 3

end

eig1 = q + 2 * p * cos(phi)

eig3 = q + 2 * p * cos(phi + (2*pi/3))

eig2 = 3 * q - eig1 - eig3

endГде A — исходная матрица 3х3; I — единичная матрица 3х3; eig1, eig2, eig2 — собственные значения; trace() — возвращает след матрицы; det() — возвращает детерминант матрицы.

Теперь мы можем найти собственные векторы. Для этого в уравнение:

подставим одно из найденных собственных значений вместо . Найденный вектор

и будет являться собственным вектором. Таких векторов получится три:

— по одному для каждого собственного значения. Собственные значения и векторы необходимо отсортировать в таком порядке

, при этом векторы тоже меняются местами, т.е. меняя местами значения

и

мы также меняем местами

и

. Если после сортировки выполняется условие

, то считается, что воксель, в котором построили матрицу, принадлежит сосуду. При этом собственный вектор

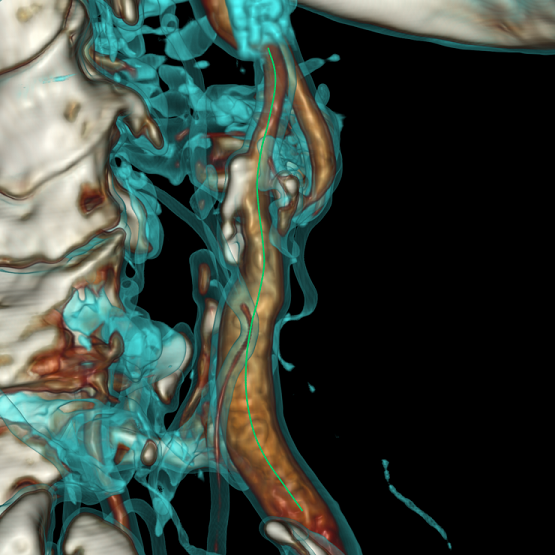

будет указывать направление вдоль сосуда независимо от того как близко к стенке находится воксель:

Если воксель принадлежит сосуду, то на основании собственных значений матрицы рассчитывается так называемая сосудистость. В литературе встречается очень много разных формул, и мы адаптировали под себя одну из них:

— соответственно, значение сосудистости

Чем больше сосудистость, тем ближе воксель к центру сосуда. Теперь несложно представить простой алгоритм поиска центральной линии из заданного вокселя:

- Определяем направление сосуда в текущем вокселе,

- Делаем перпендикулярный направлению срез сосуда и перемещаемся по градиенту в воксель среза с максимальной сосудистостью,

- Определяем направление сосуда в вокселе с максимальной сосудистостью,

- Делаем небольшой шаг в направлении сосуда и попадаем в новый воксель,

- Возвращаемся в шаг 1.

Из первоначальной точки движение происходит в двух направлениях, потому что мы не можем заранее знать, какое из них нам нужно:

Анимация алгоритма

В результате получаем не самую красивую, но корректную центральную линию:

Чтобы центральная линия стала менее угловатой, необходимо отказаться от целочисленных координат вокселей и перейти к дробным координатам точек в 3D-пространстве, также можно выполнить небольшое сглаживание центральной линии после построения.

Для перехода к дробным координатам мы воспользовались бикубической интерполяцией при получении значений интенсивности. Общее уравнение фильтра в одномерном пространстве выглядит так:

где и

имеют предопределенные значения. Если

, то мы имеем дело с B-сплайном, если

, то с кардинальным сплайном. В нашем случае

,

(Catmull-Rom filter). Тогда получаем:

Рассмотрим случай для 1D. Если даны значения в точках c координатами

, и мы интерполируем

, где

, то мы можем вычислить вес для каждой вершины:

Итоговое проинтерполированное значение:

Теперь рассмотрим наш полноценный случай для 3D пространства. Как нетрудно догадаться, мы будем интерполировать внутри куба размерностью 4х4х4 вокселя. За основу берем веса, рассмотренные для 1D случая:

где — дробные координаты точки,

— интенсивность в вокселе с координатами

,

— округление в меньшую сторону.

Для кого-то может показаться интересным факт, что сумма весов всех вокселей равна 1:

Детали

Вернемся к вычислению производных для матрицы Гессе. У нас есть координаты и интенсивность, как численно считается вторая частная производная все знают: основным является метод конечных разностей. Для точки :

Формула

Для устранения шума перед вычислением производных необходимо выполнить сглаживание Гаусса с некоторым значением и только потом вычислять матрицу Гессе в конкретной точке уже по сглаженным значениям интенсивности. Сглаживание Гаусса в точке

:

где возвращает значение интенсивности в точке

;

обычно принимает значение

(

— округление в большую сторону);

— коэффициент сглаживания.

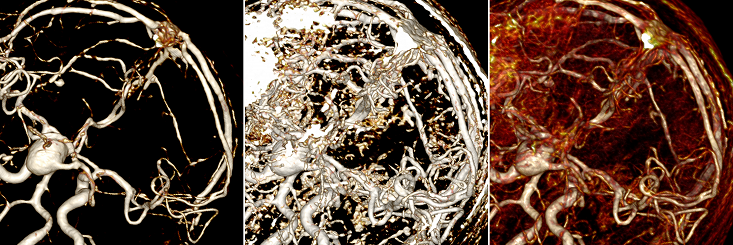

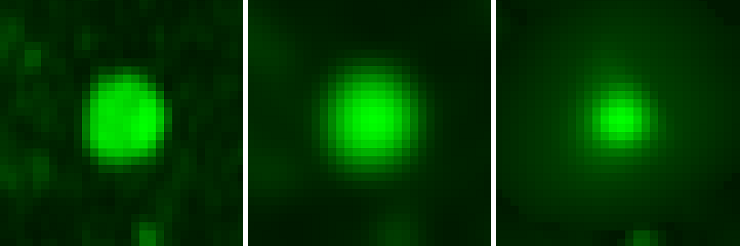

Значения интенсивности в перпендикулярном срезе сосуда до сглаживания, после сглаживания, на третьем рисунке значения сосудистости:

При этом, чем большее значение мы используем, тем более толстые сосуды мы пробуем найти. А поскольку нам нужны вообще все сосуды — и тонкие, и толстые, то нам нужно много значений

, и для каждого значения нам следует выполнить сглаживание. Мы остановились на диапазоне

, который включает в себя 10 значений.

Однако, с ростом уменьшаются значениях вторых производных. Это, в свою очередь, приводит к тому, что сосудистость, рассчитанная с большой

, оказывается меньше сосудистости, рассчитанной в той же точке с маленькой

, даже если в действительности мы имеем дело с толстым сосудом. Получается, что независимо от реальной картины всегда преобладают структуры, напоминающие тонкие сосуды. Поэтому возникает вопрос: как соотнести друг с другом все полученные сосудистости для каждой из

? Для этого необходимо выполнить нормализацию между результатами вычислений. В литературе обычно проводятся манипуляции с полученной сосудистостью, например:

, где

— нормализованная сосудистость,

— сосудистость, полученная для сглаживания с

,

подбирается экспериментально, хороший вариант 0.5.

Мы же воспользовались так называемой гамма-нормализацией: , где

— матрица Гессе,

— порядок производной, т.е. 2,

подбирается экспериментально, в нашем случае хорошо себя показал вариант 0.5. Тогда вся формула сводится к

.

Теперь, если мы попытаемся вычислить значение сосудистости с маленькой в центре идеально тонкого сосуда, то оно будет примерно равно значению сосудистости с большой

для центра идеально толстого сосуда.

Алгоритм вычислений для произвольной точки при построении центральной линии выглядит так:

- Рассчитать собственные векторы матрицы Гессе, для которой сосудистость оказалась максимальной, и получить вектор-направление сосуда.

Совмещая этот алгоритм с алгоритмом построения центральной линии мы получим финальный результат:

Оптимизация

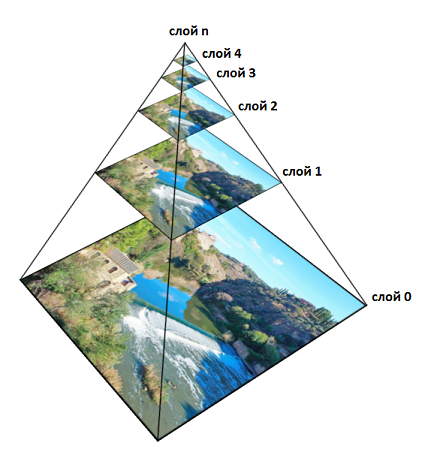

Описанный выше подход будет работать прекрасно, но есть несколько моментов. Во-первых, для повышения производительности сглаживание необходимо заранее выполнять сразу для всех вокселей и для всех . Во-вторых, с учетом того, что исследования обычно имеют размер примерно 512х512х512 вокселей, размер памяти, требуемой для хранения результатов сглаживания, в среднем будет занимать около 5 Гб. Чтобы сократить количество расходуемой памяти мы воспользовались пирамидой (scale space pyramid).

Идея заключается в том, что раз уж после каждого сглаживания значения интенсивности в соседних вокселях размываются и становятся примерно равными, то нет смысла хранить их все. Т.е. чем больше , тем меньше нам потом потребуется просчитанных вокселей, чтобы восстановить сглаживание по всему объему.

В общем случае работает это так. Нулевой слой объема является оригинальным. Вдоль каждой из осей объема несколько раз применяется сглаживающий фильтр (¼, ½, ¼), и после размерность объема уменьшается в два раза. Полученный объем будет принадлежать первому слою. Затем операция повторяется и получается второй слой. Потом третий и т.д. Каждому слою соответствует определенное значение . Пример для 2D:

Нетрудно посчитать, что в 3D суммарное количество памяти будет равно , где

— количество памяти, требуемое для хранения оригинального объема. Однако, использование пирамиды таит в себе очень много трудностей и проблем, с которыми мы столкнулись, и которые тянут на отдельную статью, если про них рассказывать.

Итог

Можно считать изложенный подход построения центральной линии крайне эффективным, но он обладает некоторыми недостатками:

- Для КТ исследований не удается обнаружить сосуды, которые проходят внутри костей (как, например, в позвоночнике)

- Не всегда удается обнаружить сосуды, если они проходят вблизи вытянутых продолговатых костей, тканей или структур (в таких случаях кости, ткани и структуры сами могут ошибочно приниматься за сосуды)

- Узким местом являются бифуркации (раздвоения сосудов)

Проблемы 1 и 2 решаются путем вычитания костей. Для этого необходимо два КТ исследования — с контрастом и без. Понятно, что единственным отличием таких исследований будут являться подсвеченные сосуды. Другими словами, если вычесть интенсивность каждого вокселя исследования без сосудов из интенсивности каждого вокселя исследования с сосудами, то в результате ненулевую интенсивность будут иметь только воксели, относящиеся к сосудам. Но поскольку два исследования нельзя сделать с абсолютно одинаковым положением тела пациента, то главной проблемой становится совмещение двух исследований в 3D-пространстве. Для этого используется трансформация поворотом и смещением. Ориентация в пространстве идет по костям, т.к. они представляют собой жесткие структуры. Для нахождения костей мы воспользовались очень интересным алгоритмом водопадов, основанных на графах (waterfall based on graphs).

Проблема бифуркаций же решается указанием начальной и конечной точек сосуда, между которыми необходимо построить центральную линию. Ее нужно начать строить в каждой из двух точек в каждом из двух направлений, а при пересечении центральных линий просто объединить их в одну. Т.к. сосуды ветвятся только в одном направлении (более толстые разбиваются на более мелкие в случае артерий, и более тонкие объединяются в более толстые в случае вен), то такой подход позволяет соединить две заданных точки.

На этом все, спасибо за внимание. На всякий случай ссылка на продукт.

From Wikipedia, the free encyclopedia

In mathematics, the Hessian matrix or Hessian is a square matrix of second-order partial derivatives of a scalar-valued function, or scalar field. It describes the local curvature of a function of many variables. The Hessian matrix was developed in the 19th century by the German mathematician Ludwig Otto Hesse and later named after him. Hesse originally used the term «functional determinants».

Definitions and properties[edit]

Suppose

That is, the entry of the ith row and the jth column is

If furthermore the second partial derivatives are all continuous, the Hessian matrix is a symmetric matrix by the symmetry of second derivatives.

The determinant of the Hessian matrix is called the Hessian determinant.[1]

The Hessian matrix of a function

Applications[edit]

Inflection points[edit]

If

Second-derivative test[edit]

The Hessian matrix of a convex function is positive semi-definite. Refining this property allows us to test whether a critical point

If the Hessian is positive-definite at

For positive-semidefinite and negative-semidefinite Hessians the test is inconclusive (a critical point where the Hessian is semidefinite but not definite may be a local extremum or a saddle point). However, more can be said from the point of view of Morse theory.

The second-derivative test for functions of one and two variables is simpler than the general case. In one variable, the Hessian contains exactly one second derivative; if it is positive, then

Equivalently, the second-order conditions that are sufficient for a local minimum or maximum can be expressed in terms of the sequence of principal (upper-leftmost) minors (determinants of sub-matrices) of the Hessian; these conditions are a special case of those given in the next section for bordered Hessians for constrained optimization—the case in which the number of constraints is zero. Specifically, the sufficient condition for a minimum is that all of these principal minors be positive, while the sufficient condition for a maximum is that the minors alternate in sign, with the

Critical points[edit]

If the gradient (the vector of the partial derivatives) of a function

The Hessian matrix plays an important role in Morse theory and catastrophe theory, because its kernel and eigenvalues allow classification of the critical points.[2][3][4]

The determinant of the Hessian matrix, when evaluated at a critical point of a function, is equal to the Gaussian curvature of the function considered as a manifold. The eigenvalues of the Hessian at that point are the principal curvatures of the function, and the eigenvectors are the principal directions of curvature. (See Gaussian curvature § Relation to principal curvatures.)

Use in optimization[edit]

Hessian matrices are used in large-scale optimization problems within Newton-type methods because they are the coefficient of the quadratic term of a local Taylor expansion of a function. That is,

where

Such approximations may use the fact that an optimization algorithm uses the Hessian only as a linear operator

Letting

that is,

so if the gradient is already computed, the approximate Hessian can be computed by a linear (in the size of the gradient) number of scalar operations. (While simple to program, this approximation scheme is not numerically stable since

Notably regarding Randomized Search Heuristics, the evolution strategy’s covariance matrix adapts to the inverse of the Hessian matrix, up to a scalar factor and small random fluctuations.

This result has been formally proven for a single-parent strategy and a static model, as the population size increases, relying on the quadratic approximation.[7]

Other applications[edit]

The Hessian matrix is commonly used for expressing image processing operators in image processing and computer vision (see the Laplacian of Gaussian (LoG) blob detector, the determinant of Hessian (DoH) blob detector and scale space). It can be used in normal mode analysis to calculate the different molecular frequencies in infrared spectroscopy.[8] It can also be used in local sensitivity and statistical diagnostics.[9]

Generalizations[edit]

Bordered Hessian[edit]

A bordered Hessian is used for the second-derivative test in certain constrained optimization problems. Given the function

![{displaystyle Lambda (mathbf {x} ,lambda )=f(mathbf {x} )+lambda [g(mathbf {x} )-c]:}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f71322141bef1b2e513a469a133dccfa1808dda4)

If there are, say,

The above rules stating that extrema are characterized (among critical points with a non-singular Hessian) by a positive-definite or negative-definite Hessian cannot apply here since a bordered Hessian can neither be negative-definite nor positive-definite, as

The second derivative test consists here of sign restrictions of the determinants of a certain set of

Specifically, sign conditions are imposed on the sequence of leading principal minors (determinants of upper-left-justified sub-matrices) of the bordered Hessian, for which the first

Vector-valued functions[edit]

If

then the collection of second partial derivatives is not a

This tensor degenerates to the usual Hessian matrix when

Generalization to the complex case[edit]

In the context of several complex variables, the Hessian may be generalized. Suppose

Generalizations to Riemannian manifolds[edit]

Let

where this takes advantage of the fact that the first covariant derivative of a function is the same as its ordinary differential. Choosing local coordinates

where

See also[edit]

- The determinant of the Hessian matrix is a covariant; see Invariant of a binary form

- Polarization identity, useful for rapid calculations involving Hessians.

- Jacobian matrix – Matrix of all first-order partial derivatives of a vector-valued function

- Hessian equation

Notes[edit]

- ^ Binmore, Ken; Davies, Joan (2007). Calculus Concepts and Methods. Cambridge University Press. p. 190. ISBN 978-0-521-77541-0. OCLC 717598615.

- ^ Callahan, James J. (2010). Advanced Calculus: A Geometric View. Springer Science & Business Media. p. 248. ISBN 978-1-4419-7332-0.

- ^ Casciaro, B.; Fortunato, D.; Francaviglia, M.; Masiello, A., eds. (2011). Recent Developments in General Relativity. Springer Science & Business Media. p. 178. ISBN 9788847021136.

- ^ Domenico P. L. Castrigiano; Sandra A. Hayes (2004). Catastrophe theory. Westview Press. p. 18. ISBN 978-0-8133-4126-2.

- ^ Nocedal, Jorge; Wright, Stephen (2000). Numerical Optimization. Springer Verlag. ISBN 978-0-387-98793-4.

- ^ Pearlmutter, Barak A. (1994). «Fast exact multiplication by the Hessian» (PDF). Neural Computation. 6 (1): 147–160. doi:10.1162/neco.1994.6.1.147. S2CID 1251969.

- ^ Shir, O.M.; A. Yehudayoff (2020). «On the covariance-Hessian relation in evolution strategies». Theoretical Computer Science. Elsevier. 801: 157–174. doi:10.1016/j.tcs.2019.09.002.

- ^ Mott, Adam J.; Rez, Peter (December 24, 2014). «Calculation of the infrared spectra of proteins». European Biophysics Journal. 44 (3): 103–112. doi:10.1007/s00249-014-1005-6. ISSN 0175-7571. PMID 25538002. S2CID 2945423.

- ^ Liu, Shuangzhe; Leiva, Victor; Zhuang, Dan; Ma, Tiefeng; Figueroa-Zúñiga, Jorge I. (March 2022). «Matrix differential calculus with applications in the multivariate linear model and its diagnostics». Journal of Multivariate Analysis. 188: 104849. doi:10.1016/j.jmva.2021.104849.

- ^ Hallam, Arne (October 7, 2004). «Econ 500: Quantitative Methods in Economic Analysis I» (PDF). Iowa State.

- ^ Neudecker, Heinz; Magnus, Jan R. (1988). Matrix Differential Calculus with Applications in Statistics and Econometrics. New York: John Wiley & Sons. p. 136. ISBN 978-0-471-91516-4.

- ^ Chiang, Alpha C. (1984). Fundamental Methods of Mathematical Economics (Third ed.). McGraw-Hill. p. 386. ISBN 978-0-07-010813-4.

Further reading[edit]

- Lewis, David W. (1991). Matrix Theory. Singapore: World Scientific. ISBN 978-981-02-0689-5.

- Magnus, Jan R.; Neudecker, Heinz (1999). «The Second Differential». Matrix Differential Calculus : With Applications in Statistics and Econometrics (Revised ed.). New York: Wiley. pp. 99–115. ISBN 0-471-98633-X.

External links[edit]

- «Hessian of a function», Encyclopedia of Mathematics, EMS Press, 2001 [1994]

- Weisstein, Eric W. «Hessian». MathWorld.

Применение поверхностей первого и второго порядков

в задачах на экстремум функций

Общая постановка задачи поиска экстремума функций приведена здесь. Рассмотрим задачу поиска безусловного экстремума функций двух переменных.

Аналитический метод поиска локального безусловного экстремума

Пусть задана дважды непрерывно дифференцируемая функция двух переменных.

Точка называется точкой локального минимума, если существует такая окрестность этой точки, для всех точек которой выполняется условие

Если знак неравенства заменить на знак

, то получится определение локального максимума. Точки локального минимума или максимума называются точками локального экстремума функции.

Требуется найти точки локального экстремума функции .

Порядок решения поставленной задачи содержит два этапа.

На первом этапе при помощи необходимых условий экстремума первого порядка:

(4.74)

находятся стационарные точки , «подозрительные» на наличие локального экстремума (частные производные первого порядка в точке

равны нулю).

На втором этапе проверяются достаточные условия экстремума, а если они не выполняются, то и необходимые условия второго порядка. Они следуют из формулы Тейлора для приращения функции в точке (учитывая члены до второго порядка включительно):

где

а члены с производными первого порядка отсутствуют, так как точка удовлетворяет (4.74).

Равенство

(4.75)

можно рассматривать как уравнение поверхности второго порядка относительно неизвестных

. Уравнение (4.75) можно записать в матричной форме

(4.76)

где — матрица квадратичной формы, называемая матрицей Гессе.

Она составлена из частных производных второго порядка, вычисленных в стационарной точке

Как показано в разд.4.4.1, при помощи поворота системы координат вокруг оси можно квадратичную форму в правой части (4.76) привести к каноническому виду

(4.77)

где — собственные значения матрицы Гессе

.

В зависимости от знаков собственных значений возможны следующие случаи:

1) если собственные значения одного знака, то поверхность (4.77) представляет собой эллиптический параболоид: выпуклый при

(рис.4.58,а), или вогнутый при

(рис.4.58,б);

2) если собственные значения имеют разные знаки, то поверхность (4.77) представляет собой гиперболический параболоид (рис.4.58,в при

);

3) если одно из собственных значений равно нулю (например, при ), то поверхность (4.77) представляет собой параболический цилиндр: выпуклый при

(рис.4.58,2) или вогнутый при

(рис.4.58,д).

В случае эллиптического параболоида стационарная точка является либо точкой локального минимума функции при

, либо точкой локального максимума функции при

. В случае гиперболического параболоида (

и

имеют разные знаки) в стационарной точке

нет экстремума. В случае выпуклого параболического цилиндра можно сказать, что точка

не может быть точкой максимума, но может быть точкой минимума, в случае вогнутого параболического цилиндра точка

не может быть точкой минимума, но может быть точкой максимума. Таким образом, если хотя бы одно собственное значение равно нулю, судить о наличии экстремума в точке

нельзя, так как нужны дополнительные исследования, учитывающие в формуле Тейлора члены выше второго порядка.

Алгоритм исследования функции на локальный экстремум

1. Составить и решить систему (4.74) — найти стационарные точки . Если система не имеет решения, то точек локального экстремума нет.

2. Составить матрицу Гессе и найти ее собственные значения

и

, решая характеристическое уравнение

3. Проверить выполнение следующих условий.

а) Если

, то

— точка локального минимума.

б) Если

, то

— точка локального максимума.

в) Если

, то

может быть точкой локального минимума (требуется дополнительное исследование).

г) Если

, то

может быть точкой локального максимума (требуется дополнительное исследование).

д) Если и

разных знаков

, то

не является точкой локального экстремума.

Пример 4.25. Найти экстремумы функции .

Решение.. Решая систему уравнений

находим стационарные точки и

.

Составляем матрицу Гессе .

В стационарной точке матрица Гессе

. Найдем собственные значения матрицы Гессе. Характеристическое уравнение

имеет корни разных знаков. Следовательно, точка

не является точкой экстремума (см. п.3,»д» алгоритма).

В стационарной точке матрица Гессе

. Характеристическое уравнение

имеет два положительных корня . Следовательно, точка

является точкой минимума (см. п.3,»а» алгоритма).

Применение графических методов поиска экстремума функции

Рассмотрим постановку задачи поиска условного экстремума функции трех переменных. Пусть заданы:

а) функция трех переменных

;

б) множество допустимых решений .

Требуется найти такую точку из множества допустимых решений, которой соответствует минимальное значение функции

на этом множестве:

Алгоритм графического метода поиска условного (или безусловного экстремума) функции аналогичен алгоритму, рассмотренному ранее для функции двух переменных. Однако его применение на практике ограничивается возможностями изображения пространственных фигур. Как правило, используется плоское изображение пространственных фигур, т.е. проекции этих фигур на плоскость, что не дает полного представления о взаимном их расположении.

Ниже рассматриваются задачи, в которых минимизируемая функция и функции, задающие ограничения, являются многочленами трех переменных первой или второй степени. Построение множества допустимых решений и поверхностей уровня функции сводится к построению алгебраических поверхностей первого или второго порядков. В этих задачах применение графического метода упрощается.

Напомним, что поверхностью уровня функции называется геометрическое место точек пространства, в которых функция принимает постоянное значение, т.е.

.

Если функция является многочленом первой степени, то ее поверхности уровня

при разных значениях постоянной

представляют собой семейство параллельных плоскостей (несобственный пучок плоскостей).

Если функция является многочленом второй степени, то ее поверхности уровня

при разных значениях постоянной

представляют собой поверхности второго порядка. Поскольку уравнения разных поверхностей уровня отличаются только свободными членами, то собственные векторы, собственные значения

, а также инварианты

остаются постоянными для всех поверхностей уровня

. Следовательно, тип поверхности и канонический базис остаются постоянными для всех поверхностей уровня квадратичной функции.

Пример 4.26. Графическим методом найти экстремумы:

Решение.

1) 1. Множество допустимых решений строить не нужно, так как оно совпадает со всем пространством:

.

2. Поверхность уровня при

представляет собой эллипсоид (рис.4.59,а), при

— мнимый конус с единственной вещественной точкой

, при

— мнимый эллипсоид. При увеличении постоянной

полуоси эллипсоида пропорционально увеличиваются. На рис.4.59,а изображены эллипсоиды

и

Стрелками указаны направления наискорейшего возрастания функции.

3. Из пункта 2 следует, что допустимые значения функции определяются не равенством .

4. В точке достигается безусловный минимум функции, так как в этой точке функция принимает наименьшее значение по сравнению со значениями в других точках пространства, а наибольшего значения функция не достигает.

2) Решается задача поиска условного экстремума с ограничениями типа равенств и неравенств.

1. Строим множество допустимых решений — часть плоскости

в первом октанте, т.е. плоский треугольник с вершинами

(рис.4.59,б).

2. Поверхности уровня функции

представляют собой семейство параллельных плоскостей, каждая из которых перпендикулярна оси аппликат. На рис.4.59,б изображены три плоскости уровня

. При

или

плоскость

не имеет общих точек с треугольником

; при

плоскость

имеет общие точки с треугольником

, в частности, при

плоскости

принадлежит сторона

треугольника, при

плоскости

принадлежит вершина

треугольника.

3. Из пункта 2 следует, что допустимые значения функции определяются неравенством .

4. Наименьшее значение на множестве , равное нулю, функция достигает в любой точке отрезка

; наибольшее значение на множестве

, равное единице, функция достигает в точке

.

3) Решается задача поиска условного экстремума с ограничением типа равенств.

1. Строим множество допустимых решений — сфера

единичного радиуса с центром в начале координат (рис.4.60).

2. Поверхности уровня представляют собой либо однополостный гиперболоид вращения при

(например, однополостный гиперболоид

(рис.4.60,а)), либо круговой конус

при

(рис.4.60,б), либо двуполостный гиперболоид вращения при

(например, двуполостный гиперболоид

(рис.4.60,в)). При

поперечные полуоси однополостного гиперболоида

больше единицы, и он не имеет общих точек со сферой единичного радиуса. При

продольная полуось двуполостного гиперболоида

больше единицы, и он не имеет общих точек со сферой

. При

поверхность уровня

имеет общие точки с заданной сферой.

3. Из п.2 следует, что допустимые значения функции определяются неравенством .

4. Наименьшее значение на множестве , равное –1, функция достигает в точках

— вершинах двуполостного гиперболоида

(рис.4.60,в); наибольшее значение на множестве

, равное единице, функция достигает в точках окружности

т.е. в точках горлового эллипса (в данном случае окружности) однополостного гиперболоида вращения

(рис.4.60,а).

Математический форум (помощь с решением задач, обсуждение вопросов по математике).

Если заметили ошибку, опечатку или есть предложения, напишите в комментариях.

![{displaystyle mathbf {H} _{f}={begin{bmatrix}{dfrac {partial ^{2}f}{partial x_{1}^{2}}}&{dfrac {partial ^{2}f}{partial x_{1},partial x_{2}}}&cdots &{dfrac {partial ^{2}f}{partial x_{1},partial x_{n}}}\[2.2ex]{dfrac {partial ^{2}f}{partial x_{2},partial x_{1}}}&{dfrac {partial ^{2}f}{partial x_{2}^{2}}}&cdots &{dfrac {partial ^{2}f}{partial x_{2},partial x_{n}}}\[2.2ex]vdots &vdots &ddots &vdots \[2.2ex]{dfrac {partial ^{2}f}{partial x_{n},partial x_{1}}}&{dfrac {partial ^{2}f}{partial x_{n},partial x_{2}}}&cdots &{dfrac {partial ^{2}f}{partial x_{n}^{2}}}end{bmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3415c5d5fc9cdae0acb6b3d4666a3c26d06da915)

![{displaystyle mathbf {H} (mathbf {x} )mathbf {v} ={frac {1}{r}}left[nabla f(mathbf {x} +rmathbf {v} )-nabla f(mathbf {x} )right]+{mathcal {O}}(r)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e7655a1df4945c74b185fc3f94a4991346994fc6)

![{displaystyle mathbf {H} (Lambda )={begin{bmatrix}{dfrac {partial ^{2}Lambda }{partial lambda ^{2}}}&{dfrac {partial ^{2}Lambda }{partial lambda partial mathbf {x} }}\left({dfrac {partial ^{2}Lambda }{partial lambda partial mathbf {x} }}right)^{mathsf {T}}&{dfrac {partial ^{2}Lambda }{partial mathbf {x} ^{2}}}end{bmatrix}}={begin{bmatrix}0&{dfrac {partial g}{partial x_{1}}}&{dfrac {partial g}{partial x_{2}}}&cdots &{dfrac {partial g}{partial x_{n}}}\[2.2ex]{dfrac {partial g}{partial x_{1}}}&{dfrac {partial ^{2}Lambda }{partial x_{1}^{2}}}&{dfrac {partial ^{2}Lambda }{partial x_{1},partial x_{2}}}&cdots &{dfrac {partial ^{2}Lambda }{partial x_{1},partial x_{n}}}\[2.2ex]{dfrac {partial g}{partial x_{2}}}&{dfrac {partial ^{2}Lambda }{partial x_{2},partial x_{1}}}&{dfrac {partial ^{2}Lambda }{partial x_{2}^{2}}}&cdots &{dfrac {partial ^{2}Lambda }{partial x_{2},partial x_{n}}}\[2.2ex]vdots &vdots &vdots &ddots &vdots \[2.2ex]{dfrac {partial g}{partial x_{n}}}&{dfrac {partial ^{2}Lambda }{partial x_{n},partial x_{1}}}&{dfrac {partial ^{2}Lambda }{partial x_{n},partial x_{2}}}&cdots &{dfrac {partial ^{2}Lambda }{partial x_{n}^{2}}}end{bmatrix}}={begin{bmatrix}0&{dfrac {partial g}{partial mathbf {x} }}\left({dfrac {partial g}{partial mathbf {x} }}right)^{mathsf {T}}&{dfrac {partial ^{2}Lambda }{partial mathbf {x} ^{2}}}end{bmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c0cd792434fccdc124364b8ce1ca395c75288482)